在网站运营过程中,许多站长都遭遇过这样的困扰:大量来自国外的垃圾蜘蛛和恶意爬虫不断抓取网站内容,不仅消耗宝贵的带宽资源,严重时甚至可能导致网站宕机。本文将详细介绍如何有效识别并屏蔽这些无用蜘蛛,从而优化网站性能,提升访问速度。

为什么需要屏蔽垃圾蜘蛛?

垃圾蜘蛛和恶意爬虫对网站的危害不容忽视:

- 带宽资源被大量占用:这些爬虫频繁抓取会消耗服务器带宽,影响正常用户访问

- 服务器负载增加:大量并发请求可能导致服务器响应变慢甚至崩溃

- 无实际价值:这些蜘蛛抓取的数据不会为网站带来任何流量或商业价值

- 可能被恶意利用:部分爬虫可能被用于探测网站漏洞或进行其他恶意行为

常见垃圾蜘蛛识别清单

1. MJ12Bot

英国SEO公司Majestic的爬虫,专门抓取网页数据供SEO分析使用,不会为网站带来任何实际流量。

2. AhrefsBot

知名SEO工具Ahrefs的爬虫,同样只抓取数据供其商业工具使用,对网站无益处。

3. SEMrushBot

来自SEO和营销公司SEMrush的网络爬虫,主要用于竞争对手分析。

4. DotBot

Moz.com旗下的网页爬虫,为Moz工具提供数据支持。

5. MauiBot

特殊之处在于它虽然看起来是个人开发的爬虫(UA仅显示一个邮箱地址),但却遵循robots协议。

6. MegaIndex.ru

提供反向链接查询服务的俄罗斯网站蜘蛛,主要分析网站链接结构。

7. BLEXBot

Webmeup旗下的蜘蛛,功能是收集网站链接信息,对普通网站毫无价值。

双重防护策略:彻底屏蔽垃圾蜘蛛

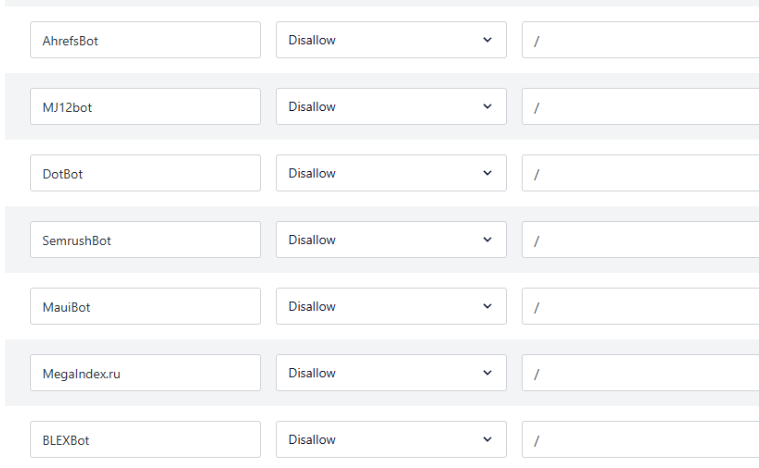

方法一:通过robots.txt禁止合规爬虫

对于遵循robots协议的蜘蛛,最有效的方法是在网站根目录下的robots.txt文件中添加禁止规则:

User-agent: SemrushBot

Disallow: /

User-agent: DotBot

Disallow: /

User-agent: MegaIndex.ru

Disallow: /

User-agent: MauiBot

Disallow: /

User-agent: AhrefsBot

Disallow: /

User-agent: MJ12bot

Disallow: /

User-agent: BLEXBot

Disallow: /

方法二:服务器层面屏蔽顽固爬虫

对于不遵守robots协议的恶意爬虫,需要在Web服务器配置中添加UA屏蔽规则:

Nginx配置示例:

if ($http_user_agent ~* (SemrushBot|DotBot|MegaIndex|MauiBot|AhrefsBot|MJ12bot|BLEXBot)) {

return 403;

}Apache配置示例:

RewriteCond %{HTTP_USER_AGENT} (SemrushBot|DotBot|MegaIndex|MauiBot|AhrefsBot|MJ12bot|BLEXBot) [NC]

RewriteRule ^.* - [F,L]进阶优化:CDN加速与防护

除了屏蔽垃圾蜘蛛外,使用CDN服务可以进一步提升网站性能和安全性:

- 全球节点缓存:将静态资源分发到全球各地节点,用户就近访问

- 带宽压力分流:CDN承担大部分流量,减轻源站服务器压力

- DDoS防护:多数CDN提供基础的安全防护能力

- 智能缓存:根据内容类型设置不同缓存策略,优化访问速度

推荐CDN服务商:Cloudflare、阿里云CDN、腾讯云CDN、AWS CloudFront等。

持续监控与优化建议

- 定期检查服务器日志,识别新的垃圾蜘蛛

- 监控带宽使用情况,评估屏蔽效果

- 根据实际需要调整robots.txt规则

- 考虑使用专业的爬虫管理工具

通过实施以上措施,您将有效减少垃圾蜘蛛带来的资源浪费,提升网站访问速度,为真实用户提供更好的浏览体验。记住,网站优化是一个持续的过程,需要定期审查和调整防护策略。