NVIDIA AI团队发布的Describe Anything 3B(DAM-3B)模型确实在多模态领域迈出了重要一步,其技术特性和开源策略对行业具有深远影响。以下从技术、应用和生态三个维度进行深入解析:

一、技术突破:细粒度视觉-语言融合

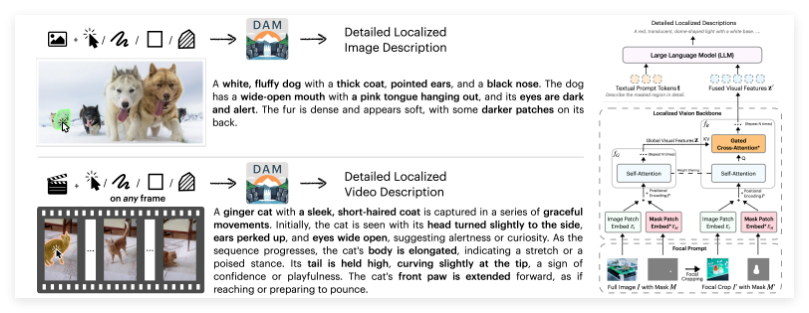

- 区域化描述的核心机制焦点提示(Focal Prompt):允许用户通过点、框、涂鸦等交互方式指定目标区域,模型结合局部视觉特征与全局上下文生成描述。这种动态聚焦能力解决了传统模型“粗粒度理解”的痛点。门控交叉注意力(Gated Cross-Attention):通过可学习的门控权重控制视觉与语言模态的信息交互,避免无关背景干扰,提升区域描述的准确性。例如,在密集场景中(如人群、复杂物体堆叠),模型能精准区分目标与其他元素。

- 架构优化双视觉编码器设计:全局编码器(CNN/ViT)捕捉整体场景,局部编码器(轻量化主干网络)提取指定区域的高分辨率特征,两者通过跨模态对齐模块融合。3B参数规模:在保持高效推理(适合边缘设备部署)的同时,性能媲美更大模型(如Flamingo-80B的细粒度任务表现)。

- 基准测试表现在RefCOCO(指代表达理解)、Visual Genome(关系检测)等7项任务中,DAM-3B在区域描述准确性和上下文相关性上超越CLIP、BLIP等模型,尤其在零样本迁移任务中展现强泛化能力。

二、开源生态:降低多模态研发门槛

- 开放资源清单数据集:包含数百万张带有区域标注的图文对(如COCO-Text、ADe20K扩展版),涵盖多样化的场景和物体。评估工具包:推出Region-Text Alignment Score(RTAS)新指标,量化模型对区域-文本匹配的精确度。Demo平台:支持用户上传自定义图像/视频,通过交互式界面测试模型(如分割掩码生成描述)。

- 社区影响开发者可基于DAM-3B微调垂直领域模型(如医疗影像报告生成、工业质检缺陷描述)。开源协议允许商用,推动创业公司快速集成到AR眼镜、智能客服等产品中。

三、行业应用场景

- 内容创作自动化视频剪辑:识别视频中的关键区域(如演员表情、特效片段),生成时间轴标记,加速后期制作。动态字幕生成:为直播或UGC视频实时添加区域化描述(如“左下角的红色跑车正在转弯”)。

- 无障碍技术视障辅助工具:结合语音合成,将周围环境中的特定物体(如交通信号灯状态、商品标签)转化为语音提示。

- 工业与医疗缺陷检测报告:在制造业中,自动描述显微镜图像中的裂纹位置与形态。医学影像分析:标注CT扫描中的病变区域,辅助医生快速定位异常。

四、挑战与未来方向

- 实时性优化:当前模型对4K视频的逐帧处理仍需较高算力,未来可能通过蒸馏技术推出轻量版(如DAM-1B)。

- 多模态幻觉问题:区域描述偶尔存在细节错误(如将“条纹衬衫”误判为“斑马纹”),需通过对抗训练进一步抑制。

- 扩展3D理解:结合NeRF等三维重建技术,实现空间中的物体关系描述。